|

| 1 | +栈是编程中使用内存最简单的方式。例如,下面的简单代码中的局部变量 n 就是在堆栈中分配内存的。 |

| 2 | + |

| 3 | +```text |

| 4 | +#include <stdio.h> |

| 5 | +void main() |

| 6 | +{ |

| 7 | + int n = 0; |

| 8 | + printf("0x%x\n",&v); |

| 9 | +} |

| 10 | +``` |

| 11 | + |

| 12 | +那么我有几个问题想问问大家,看看大家对于堆栈内存是否真的了解。 |

| 13 | + |

| 14 | +- 堆栈的物理内存是什么时候分配的? |

| 15 | +- 堆栈的大小限制是多大?这个限制可以调整吗? |

| 16 | +- 当堆栈发生溢出后应用程序会发生什么? |

| 17 | + |

| 18 | +如果你对以上问题还理解不是特别深刻,今天来带你好好修炼进程堆栈内存这块的内功! |

| 19 | + |

| 20 | +## 1、进程堆栈的初始化 |

| 21 | + |

| 22 | +进程启动调用 exec 加载可执行文件过程的时候,会给进程栈申请一个 4 KB 的初始内存。我们今天来专门抽取并看一下这段逻辑。 |

| 23 | + |

| 24 | +加载系统调用 execve 依次调用 do_execve、do_execve_common 来完成实际的可执行程序加载。 |

| 25 | + |

| 26 | +```text |

| 27 | +//file:fs/exec.c |

| 28 | +static int do_execve_common(const char *filename, ...) |

| 29 | +{ |

| 30 | + bprm_mm_init(bprm); |

| 31 | + ... |

| 32 | +} |

| 33 | +``` |

| 34 | + |

| 35 | +在 bprm_mm_init 中会申请一个全新的地址空间 mm_struct 对象,准备留着给新进程使用。 |

| 36 | + |

| 37 | +```text |

| 38 | +//file:fs/exec.c |

| 39 | +static int bprm_mm_init(struct linux_binprm *bprm) |

| 40 | +{ |

| 41 | + //申请个全新的地址空间 mm_struct 对象 |

| 42 | + bprm->mm = mm = mm_alloc(); |

| 43 | + __bprm_mm_init(bprm); |

| 44 | +} |

| 45 | +``` |

| 46 | + |

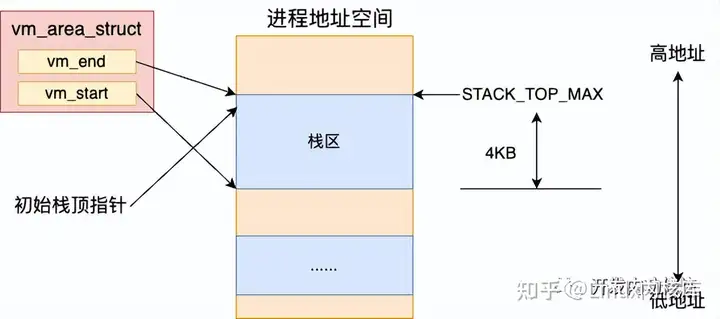

| 47 | +还会给新进程的栈申请一页大小的虚拟内存空间,作为给新进程准备的栈内存。申请完后把栈的指针保存到 bprm->p 中记录起来。 |

| 48 | + |

| 49 | +```text |

| 50 | +//file:fs/exec.c |

| 51 | +static int __bprm_mm_init(struct linux_binprm *bprm) |

| 52 | +{ |

| 53 | + bprm->vma = vma = kmem_cache_zalloc(vm_area_cachep, GFP_KERNEL); |

| 54 | + vma->vm_end = STACK_TOP_MAX; |

| 55 | + vma->vm_start = vma->vm_end - PAGE_SIZE; |

| 56 | + ... |

| 57 | +

|

| 58 | + bprm->p = vma->vm_end - sizeof(void *); |

| 59 | +} |

| 60 | +``` |

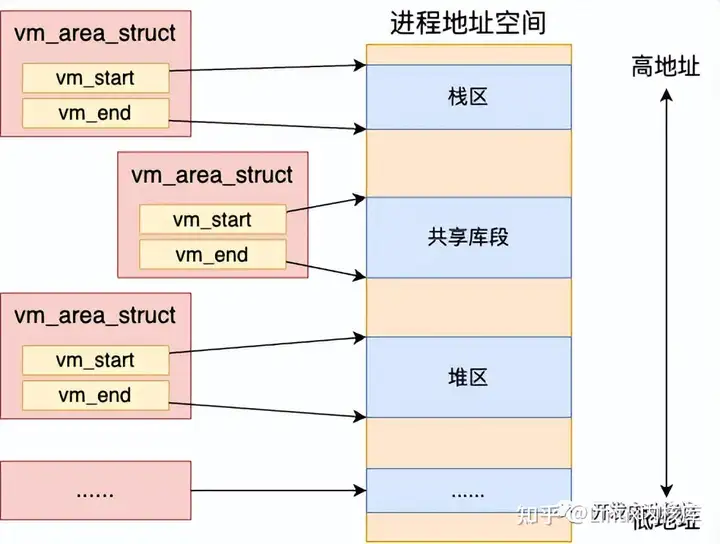

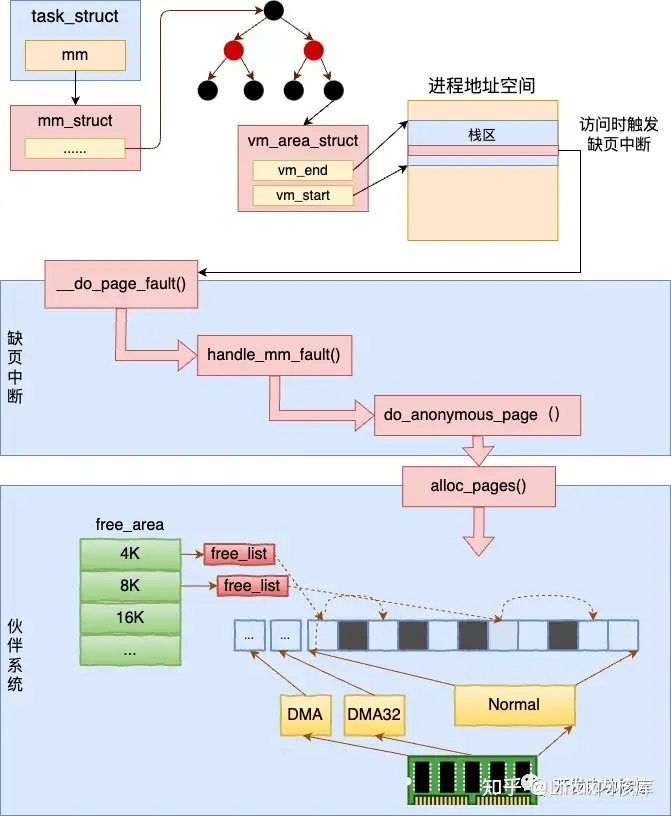

| 61 | + |

| 62 | +我们平时所说的进程虚拟地址空间在 Linux 是通过一个个的 vm_area_struct 对象来表示的。 |

| 63 | + |

| 64 | + |

| 65 | + |

| 66 | + |

| 67 | + |

| 68 | + |

| 69 | + |

| 70 | +每一个 vm_area_struct(就是上面 __bprm_mm_init 函数中的 vma)对象表示进程虚拟地址空间里的一段范围,其 vm_start 和 vm_end 表示启用的虚拟地址范围的开始和结束。 |

| 71 | + |

| 72 | +```text |

| 73 | +//file:include/linux/mm_types.h |

| 74 | +struct vm_area_struct { |

| 75 | + unsigned long vm_start; |

| 76 | + unsigned long vm_end; |

| 77 | + ... |

| 78 | +} |

| 79 | +``` |

| 80 | + |

| 81 | +**要注意的是这只是地址范围,而不是真正的物理内存分配** 。 |

| 82 | + |

| 83 | +在上面 __bprm_mm_init 函数中通过 kmem_cache_zalloc 申请了一个 vma 内核对象。vm_end 指向了 STACK_TOP_MAX(地址空间的顶部附近的位置),vm_start 和 vm_end 之间留了一个 Page 大小。**也就是说默认给栈准备了 4KB 的大小** 。最后把栈的指针记录到 bprm->p 中。 |

| 84 | + |

| 85 | + |

| 86 | + |

| 87 | + |

| 88 | + |

| 89 | + |

| 90 | + |

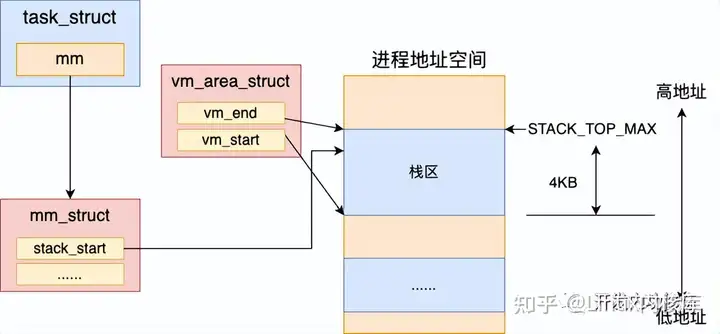

| 91 | +接下来进程加载过程会使用 load_elf_binary 真正开始加载可执行二进制程序。在加载时,会把前面准备的进程栈的地址空间指针设置到了新进程 mm 对象上。 |

| 92 | + |

| 93 | +```text |

| 94 | +//file:fs/binfmt_elf.c |

| 95 | +static int load_elf_binary(struct linux_binprm *bprm) |

| 96 | +{ //ELF 文件头解析 |

| 97 | + //Program Header 读取 |

| 98 | + //清空父进程继承来的资源 |

| 99 | + retval = flush_old_exec(bprm); |

| 100 | + ... |

| 101 | +

|

| 102 | + current->mm->start_stack = bprm->p; |

| 103 | +} |

| 104 | +``` |

| 105 | + |

| 106 | + |

| 107 | + |

| 108 | + |

| 109 | + |

| 110 | + |

| 111 | + |

| 112 | +这样新进程将来就可以使用栈进行函数调用,以及局部变量的申请了。 |

| 113 | + |

| 114 | +前面我们说了,这里只是给栈申请了地址空间对象,并没有真正申请物理内存。我们接着再来看一下,物理内存页究竟是什么时候分配的。 |

| 115 | + |

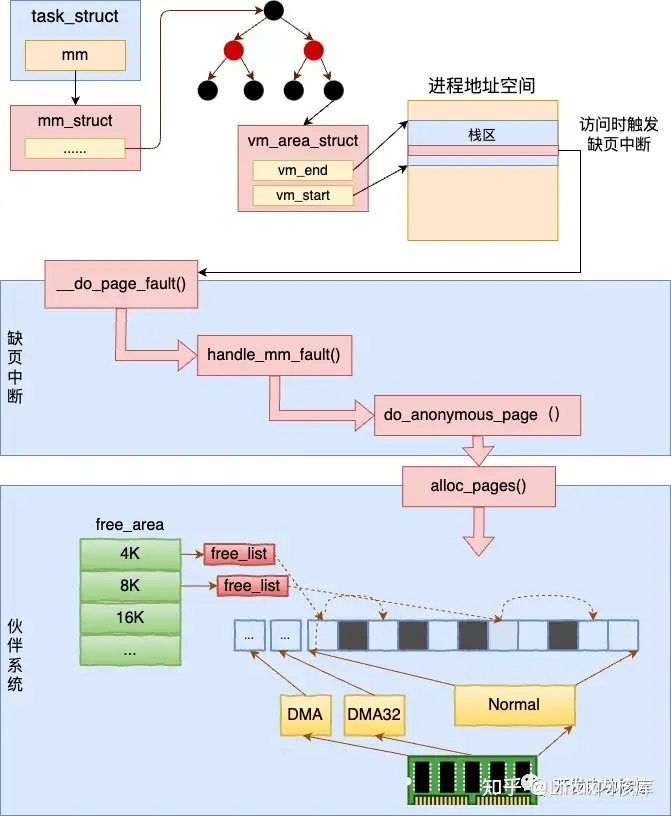

| 116 | +## 2、物理页的申请 |

| 117 | + |

| 118 | +当进程在运行的过程中在栈上开始分配和访问变量的时候,如果物理页还没有分配,会触发缺页中断。在缺页中断种来真正地分配物理内存。 |

| 119 | + |

| 120 | +为了避免篇幅过长,触发缺页中断的过程就先不展开了。我们直接看一下缺页中断的核心处理入口 __do_page_fault,它位于 arch/x86/mm/fault.c 文件下。 |

| 121 | + |

| 122 | +```text |

| 123 | +//file:arch/x86/mm/fault.c |

| 124 | +static void __kprobes |

| 125 | +__do_page_fault(struct pt_regs *regs, unsigned long error_code) |

| 126 | +{ |

| 127 | + ... |

| 128 | + //根据新的 address 查找对应的 vma |

| 129 | + vma = find_vma(mm, address); |

| 130 | +

|

| 131 | + //如果找到的 vma 的开始地址比 address 小 |

| 132 | + //那么就不调用expand_stack了,直接调用 |

| 133 | + if (likely(vma->vm_start <= address)) |

| 134 | + goto good_area; |

| 135 | + ... |

| 136 | + if (unlikely(expand_stack(vma, address))) { |

| 137 | + bad_area(regs, error_code, address); |

| 138 | + return; |

| 139 | + } |

| 140 | +good_area: |

| 141 | + //调用handle_mm_fault来完成真正的内存申请 |

| 142 | + fault = handle_mm_fault(mm, vma, address, flags); |

| 143 | +

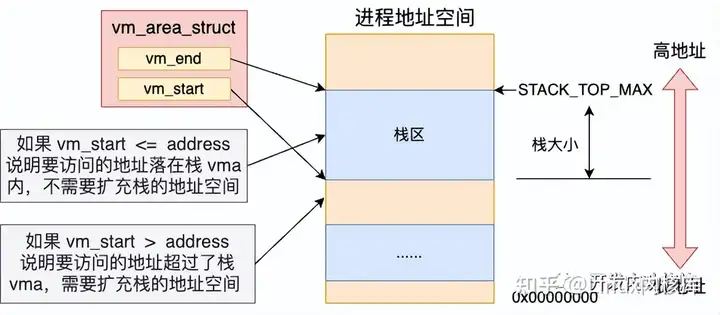

|

| 144 | +} |

| 145 | +``` |

| 146 | + |

| 147 | +当访问栈上变量的内存的时候,首先会调用 find_vma 根据变量地址 address 找到其所在的 vma 对象。接下来调用的 if (vma->vm_start <= address) 是在判断地址空间还够不够用。 |

| 148 | + |

| 149 | + |

| 150 | + |

| 151 | + |

| 152 | + |

| 153 | + |

| 154 | + |

| 155 | +如果栈内存 vma 的 start 比要访问的 address 小,则证明地址空间够用,只需要分配物理内存页就行了。如果栈内存 vma 的 start 比要访问的 address 大,则需要调用 expand_stack 先扩展一下栈的虚拟地址空间 vma。扩展虚拟地址空间的具体细节我们在第三节再讲。 |

| 156 | + |

| 157 | +这里先假设要访问的变量地址 address 处于栈内存 vma 对象的 vm_start 和 vm_end 之间。那么缺页中断处理就会跳转到 good_area 处运行。在这里调用 handle_mm_fault 来**完成真正物理内存的申请** 。 |

| 158 | + |

| 159 | +```text |

| 160 | +//file:mm/memory.c |

| 161 | +int handle_mm_fault(struct mm_struct *mm, struct vm_area_struct *vma, |

| 162 | + unsigned long address, unsigned int flags) |

| 163 | +{ |

| 164 | + ... |

| 165 | +

|

| 166 | + //依次查看每一级页表项 |

| 167 | + pgd = pgd_offset(mm, address); |

| 168 | + pud = pud_alloc(mm, pgd, address); |

| 169 | + pmd = pmd_alloc(mm, pud, address); |

| 170 | + pte = pte_offset_map(pmd, address); |

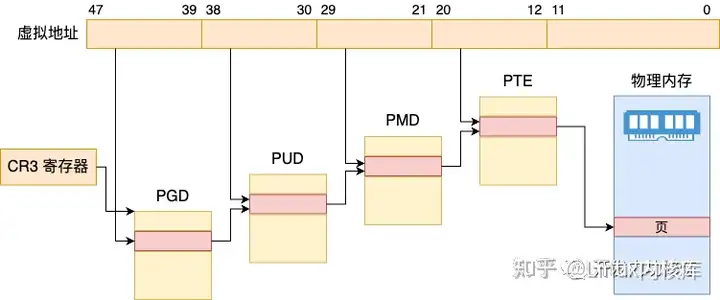

| 171 | +

|

| 172 | + return handle_pte_fault(mm, vma, address, pte, pmd, flags); |

| 173 | +} |

| 174 | +``` |

| 175 | + |

| 176 | +Linux 是用四级页表来管理虚拟地址空间到物理内存之间的映射管理的。所以在实际申请物理页面之前,需要先 check 一遍需要的每一级页表项是否存在,不存在的话需要申请。 |

| 177 | + |

| 178 | +为了好区分,Linux 还给每一级页表都起了一个名字。 |

| 179 | + |

| 180 | +- 一级页表:Page Global Dir,简称 pgd |

| 181 | +- 二级页表:Page Upper Dir,简称 pud |

| 182 | +- 三级页表:Page Mid Dir,简称 pmd |

| 183 | +- 四级页表:Page Table,简称 pte |

| 184 | + |

| 185 | +看一下下面这个图就比较好理解了 |

| 186 | + |

| 187 | + |

| 188 | + |

| 189 | + |

| 190 | + |

| 191 | + |

| 192 | + |

| 193 | +```text |

| 194 | +//file:mm/memory.c |

| 195 | +int handle_pte_fault(struct mm_struct *mm, |

| 196 | + struct vm_area_struct *vma, unsigned long address, |

| 197 | + pte_t *pte, pmd_t *pmd, unsigned int flags) |

| 198 | +{ |

| 199 | + ... |

| 200 | +

|

| 201 | + //匿名映射页处理 |

| 202 | + return do_anonymous_page(mm, vma, address, |

| 203 | + pte, pmd, flags); |

| 204 | +} |

| 205 | +``` |

| 206 | + |

| 207 | +在 handle_pte_fault 会处理很多种的内存缺页处理,比如文件映射缺页处理、swap缺页处理、写时复制缺页处理、匿名映射页处理等等几种情况。我们今天讨论的主题是栈内存,这个对应的是匿名映射页处理,会进入到 do_anonymous_page 函数中。 |

| 208 | + |

| 209 | +```text |

| 210 | +//file:mm/memory.c |

| 211 | +static int do_anonymous_page(struct mm_struct *mm, struct vm_area_struct *vma, |

| 212 | + unsigned long address, pte_t *page_table, pmd_t *pmd, |

| 213 | + unsigned int flags) |

| 214 | +{ |

| 215 | + // 分配可移动的匿名页面,底层通过 alloc_page |

| 216 | + page = alloc_zeroed_user_highpage_movable(vma, address); |

| 217 | + ... |

| 218 | +} |

| 219 | +``` |

| 220 | + |

| 221 | +在 do_anonymous_page 调用 alloc_zeroed_user_highpage_movable 分配一个可移动的匿名物理页出来。在底层会调用到伙伴系统的 alloc_pages 进行实际物理页面的分配。 |

| 222 | + |

| 223 | +内核是用伙伴系统来管理所有的物理内存页的。其它模块需要物理页的时候都会调用伙伴系统对外提供的函数来申请物理内存。 |

| 224 | + |

| 225 | + |

| 226 | + |

| 227 | + |

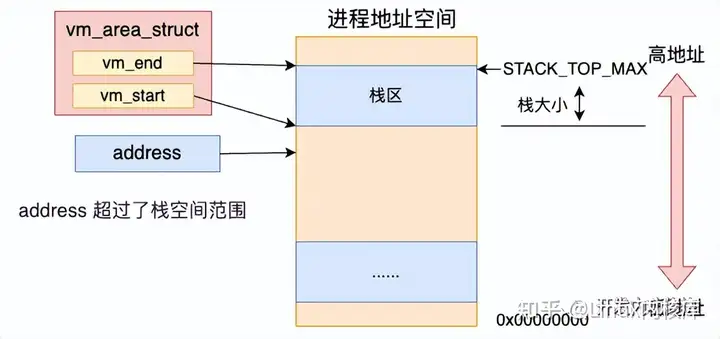

| 228 | + |

| 229 | + |

| 230 | + |

| 231 | +到了这里,开篇的问题一就有答案了,堆栈的物理内存是什么时候分配的?进程在加载的时候只是会给新进程的栈内存分配一段地址空间范围。而真正的物理内存是等到访问的时候触发缺页中断,再从伙伴系统中申请的。 |

| 232 | + |

| 233 | +## 3、栈的自动增长 |

| 234 | + |

| 235 | +前面我们看到了,进程在被加载启动的时候,栈内存默认只分配了 4 KB 的空间。那么随着程序的运行,当栈中保存的调用链,局部变量越来越多的时候,必然会超过 4 KB。 |

| 236 | + |

| 237 | +我回头看下缺页处理函数 __do_page_fault。如果栈内存 vma 的 start 比要访问的 address 大,则需要调用 expand_stack 先扩展一下栈的虚拟地址空间 vma。 |

| 238 | + |

| 239 | + |

| 240 | + |

| 241 | + |

| 242 | + |

| 243 | + |

| 244 | + |

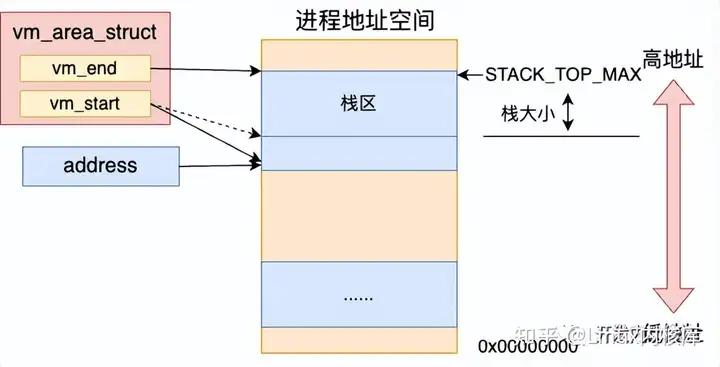

| 245 | +回顾 __do_page_fault 源码,看到扩充栈空间的是由 expand_stack 函数来完成的。 |

| 246 | + |

| 247 | +```text |

| 248 | +//file:arch/x86/mm/fault.c |

| 249 | +static void __kprobes |

| 250 | +__do_page_fault(struct pt_regs *regs, unsigned long error_code) |

| 251 | +{ |

| 252 | + ... |

| 253 | + if (likely(vma->vm_start <= address)) |

| 254 | + goto good_area; |

| 255 | + |

| 256 | + //如果栈 vma 的开始地址比 address 大,需要扩大栈 |

| 257 | + if (unlikely(expand_stack(vma, address))) { |

| 258 | + bad_area(regs, error_code, address); |

| 259 | + return; |

| 260 | + } |

| 261 | +good_area: |

| 262 | + ... |

| 263 | +} |

| 264 | +``` |

| 265 | + |

| 266 | +我们来看下 expand_stack 的内部细节。 |

| 267 | + |

| 268 | +> 其实在 Linux 栈地址空间增长是分两种方向的,一种是从高地址往低地址增长,一种是反过来。大部分情况都是由高往低增长的。本文只以向下增长为例。 |

| 269 | +

|

| 270 | +```text |

| 271 | +//file:mm/mmap.c |

| 272 | +int expand_stack(struct vm_area_struct *vma, unsigned long address) |

| 273 | +{ |

| 274 | + ... |

| 275 | + return expand_downwards(vma, address); |

| 276 | +} |

| 277 | +

|

| 278 | +int expand_downwards(struct vm_area_struct *vma, unsigned long address) |

| 279 | +{ |

| 280 | + ... |

| 281 | + //计算栈扩大后的最后大小 |

| 282 | + size = vma->vm_end - address; |

| 283 | +

|

| 284 | + //计算需要扩充几个页面 |

| 285 | + grow = (vma->vm_start - address) >> PAGE_SHIFT; |

| 286 | +

|

| 287 | + //判断是否允许扩充 |

| 288 | + acct_stack_growth(vma, size, grow); |

| 289 | +

|

| 290 | + //如果允许则开始扩充 |

| 291 | + vma->vm_start = address; |

| 292 | +

|

| 293 | + return ... |

| 294 | +} |

| 295 | +``` |

| 296 | + |

| 297 | +在 expand_downwards 中先进行了几个计算。 |

| 298 | + |

| 299 | +- 计算出新的堆栈大小。计算公式是 size = vma->vm_end - address; |

| 300 | +- 计算需要增长的页数。计算公式是 grow = (vma->vm_start - address) >> PAGE_SHIFT; |

| 301 | + |

| 302 | +然后会判断此次栈空间是否被允许扩充, 判断是在 acct_stack_growth 中完成的。如果允许扩展,则简单修改一下 vma->vm_start 就可以了! |

| 303 | + |

| 304 | + |

| 305 | + |

| 306 | + |

| 307 | + |

| 308 | + |

| 309 | + |

| 310 | +我们再来看 acct_stack_growth 都进行了哪些限制判断。 |

| 311 | + |

| 312 | +```text |

| 313 | +//file:mm/mmap.c |

| 314 | +static int acct_stack_growth(struct vm_area_struct *vma, unsigned long size, unsigned long grow) |

| 315 | +{ |

| 316 | + ... |

| 317 | + //检查地址空间是否超出限制 |

| 318 | + if (!may_expand_vm(mm, grow)) |

| 319 | + return -ENOMEM; |

| 320 | +

|

| 321 | + //检查是否超出栈的大小限制 |

| 322 | + if (size > ACCESS_ONCE(rlim[RLIMIT_STACK].rlim_cur)) |

| 323 | + return -ENOMEM; |

| 324 | + ... |

| 325 | + return 0; |

| 326 | +} |

| 327 | +``` |

| 328 | + |

| 329 | +在 acct_stack_growth 中只是进行一系列的判断。may_expand_vm 判断的是增长完这几个页后是否超出整体虚拟地址空间大小的限制。rlim[RLIMIT_STACK].rlim_cur 中记录的是栈空间大小的限制。这些限制都可以通过 ulimit 命令查看到。 |

| 330 | + |

| 331 | +```text |

| 332 | +# ulimit -a |

| 333 | +...... |

| 334 | +max memory size (kbytes, -m) unlimited |

| 335 | +stack size (kbytes, -s) 8192 |

| 336 | +virtual memory (kbytes, -v) unlimited |

| 337 | +``` |

| 338 | + |

| 339 | +上面的这个输出表示虚拟地址空间大小没有限制,栈空间的限制是 8 MB。如果进程栈大小超过了这个限制,会返回 -ENOMEM。如果觉得系统默认的大小不合适可以通过 ulimit 命令修改。 |

| 340 | + |

| 341 | +```text |

| 342 | +# ulimit -s 10240 |

| 343 | +# ulimit -a |

| 344 | +stack size (kbytes, -s) 10240 |

| 345 | +``` |

| 346 | + |

| 347 | +到这里开篇的第二个问题也有答案了,堆栈的大小限制是多大?这个限制可以调整吗? |

| 348 | +进程堆栈大小的限制在每个机器上都是不一样的,可以通过 ulimit 命令来查看,也同样可以使用该命令修改。 |

| 349 | + |

| 350 | +至于开篇的问题3,当堆栈发生溢出后应用程序会发生什么?写个简单的无限递归调用就知道了,估计你也遇到过。报错结果就是 |

| 351 | + |

| 352 | +```text |

| 353 | +'Segmentation fault (core dumped) |

| 354 | +``` |

| 355 | + |

| 356 | +## 4、本文总结 |

| 357 | + |

| 358 | +来总结下本文的内容,本文讨论了进程栈内存的工作原理。 |

| 359 | + |

| 360 | +第一,进程在加载的时候给进程栈申请了一块虚拟地址空间 vma 内核对象。vm_start 和 vm_end 之间留了一个 Page ,也就是说默认给栈准备了 4KB 的空间。 |

| 361 | +第二,当进程在运行的过程中在栈上开始分配和访问变量的时候,如果物理页还没有分配,会触发缺页中断。在缺页中断中调用内核的伙伴系统真正地分配物理内存。 |

| 362 | +第三,当栈中的存储超过 4KB 的时候会自动进行扩大。不过大小要受到限制,其大小限制可以通过 ulimit -s来查看和设置。 |

| 363 | + |

| 364 | + |

| 365 | + |

| 366 | + |

| 367 | + |

| 368 | + |

| 369 | + |

| 370 | +注意,今天我们讨论的都是进程栈。线程栈和进程栈有些不一样。 |

| 371 | + |

| 372 | +在回顾和总结下开篇我们抛出的三个问题: |

| 373 | + |

| 374 | +问题一:堆栈的物理内存是什么时候分配的?进程在加载的时候只是会给新进程的栈内存分配一段地址空间范围。而真正的物理内存是等到访问的时候触发缺页中断,再从伙伴系统中申请的。 |

| 375 | + |

| 376 | +问题二:堆栈的大小限制是多大?这个限制可以调整吗? |

| 377 | +进程堆栈大小的限制在每个机器上都是不一样的,可以通过 ulimit 命令来查看,也同样可以使用该命令修改。 |

| 378 | + |

| 379 | +问题3:当堆栈发生溢出后应用程序会发生什么?当堆栈溢出的时候,我们会收到报错 “Segmentation fault (core dumped)” |

| 380 | + |

| 381 | +最后,抛个问题大家一起思考吧。你觉得内核为什么要对进程栈的地址空间进行限制呢? |

| 382 | + |

| 383 | +------ |

| 384 | + |

| 385 | +版权声明:本文为知乎博主「Linux内核库」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文 出处链接及本声明。 |

| 386 | + |

| 387 | +原文链接:https://zhuanlan.zhihu.com/p/606284748 |

| 388 | + |

0 commit comments